量子调控的一大重要研究方向是制备多粒子纠缠态。一个常用方法是通过渐变的哈密顿从无关联的多体初态出发绝热演化到所期待的特定纠缠态。进一步基于这一概念甚至发展了绝热量子计算的思路,把特定问题的求解映射成制备特定哈密顿量的基态,最后对目标态进行测量就可以得到待解问题的答案。但是多粒子体系的能级结构复杂的而且能隙狭小,利用绝热过程需要消耗太多的时间,特别是当需要经过量子相变点附近时,在多粒子相干时间内缓慢演化的要求变得十分苛刻。同时由于量子系统的寿命都是有限的,在绝热演化过程中往往会因为损耗导致最后偏离的目标态。 在最新的工作中,物理系研究小组利用深度强化学习研究了最佳的如何调控路径,克服了绝热演化通过量子相变区域的长时间要求和有限的多粒子量子相干时间的矛盾。类似于一种广义上的绝热捷径,物理系尤力教授团队发现强化学习的神经网路巧妙地利用了激发态上更快的动力学,除了在紧邻相变点附近的区域,发现了充分利用多粒子能级结构,快速演化到特定的激发态组合,连接初态和目标态。近日,他们将这一基于深度强化学习框架的优化理论到调控旋量玻色-爱因斯坦凝聚体的态制备中,提出了耗时远短于绝热的新方案。在实验上,成功将原有的近绝热方案时间缩短了一半,并且实现了纠缠度更高的超过1万个原子的Dicke态制备,可以帮助实现更高的量子测量精度。

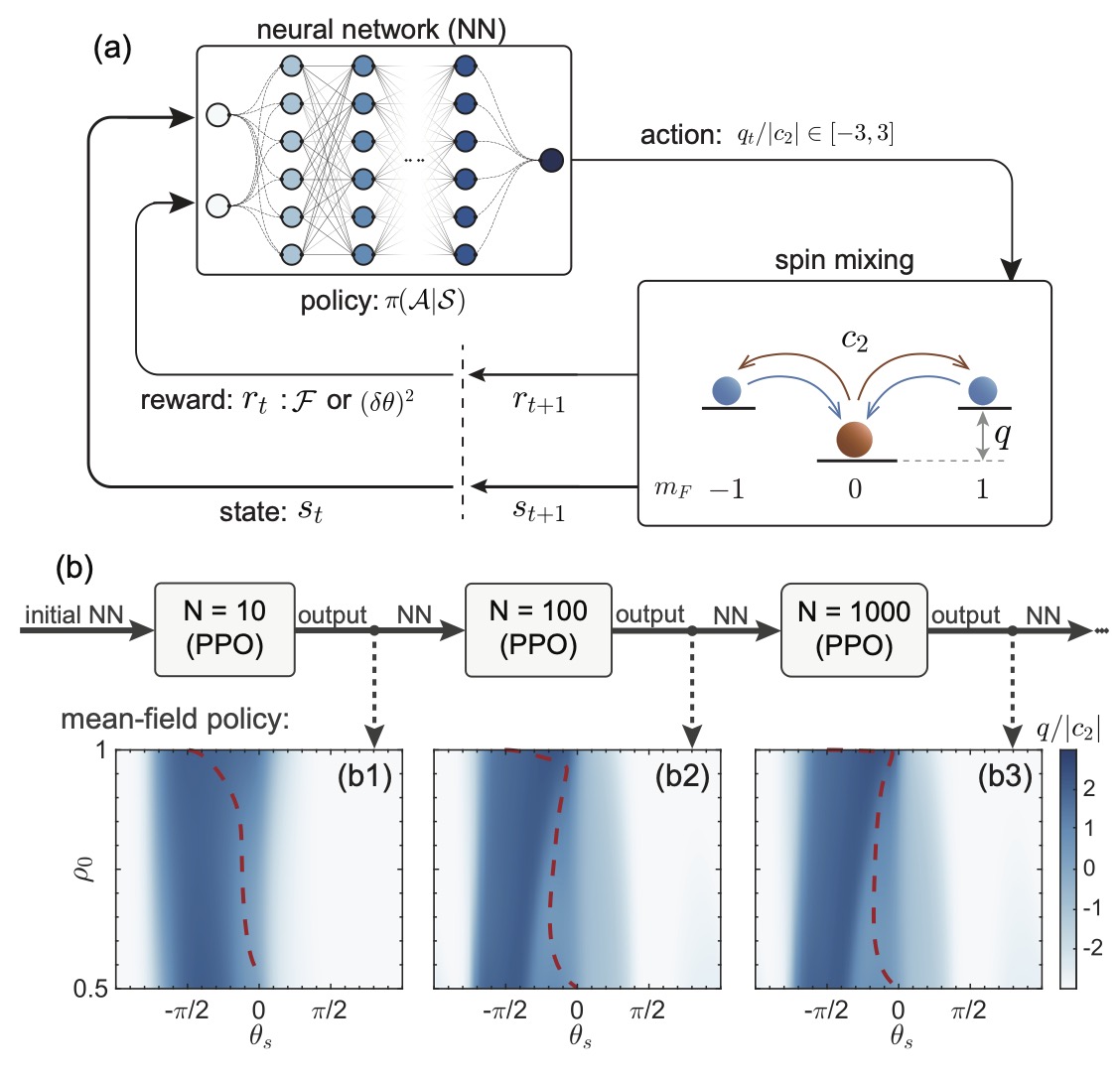

图1 强化学习框架的基本思路与迁移学习的实现。(a)智能体(深度神经网络)通过状态,动作,奖励这三种方式与环境(模拟的量子动力学)进行交互。根据这些交互的数据,该团队使用近端策略优化算法来不断地优化神经网络从而寻找最优的调控方案。(b)神经网络需要在不同大小的系统中进行训练。在指定大小的系统中完全训练目标时,网络会被迁移到更大的系统中重新训练,直到在目标大小的系统中完成训练目标。

在之前的工作中,该团队首先把所有原子制备在m_F=0的无磁矩内态上,通过近绝热地把系统的二阶塞曼能移q从3|c2|下降到0|c2|,驱动系统跨越位于2|c2|的量子临界点,在耗时1.5s之后首次实现了高度纠缠的三模Dicke态。在本次的工作中,他们采用了无模型的强化学习框架来研究二阶塞曼能移的调控方案。 强化学习智能体通过与系统不断进行交互(图1a),收集系统演化的信息,从零开始学习对系统的调控。通过迁移学习的方案,将神经网络从小系统逐渐转移到更大的系统中进行多次训练,不仅克服了直接在量子多体系统中训练时所面临的稀疏奖励问题(图1b),还可以将实验上面临的实际原子损耗加入到训练中让智能体来尽可能降低损耗的影响。最后得到能够应用到拥有1万多原子的真实实验系统的调控方案。

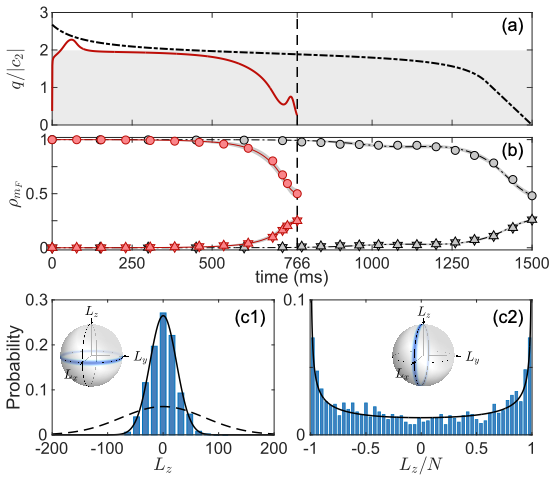

传统的绝热或者是近绝热的方案,量子态需要沿着系统的瞬时本征基态,从初态演化到目标态。在深度学习的方案里(图2a),该团队发现只有在量子临界点附近,系统的演化取决于基态附近的动力学,表现出绝热演化的行为。在其它位置,量子态均处于相干调控产生的高激发态上, 因为激发态提供了更快的动力学,使得强化学习所得到的方案可以在更短的时间之内实现目标态的制备。相较于完美的绝热方案,理论上预期可以实现同样保真度(99%)的目标态,但强化学习给出的方案缩短了接近20倍的时间。

在实验上,该团队将强化学习给出的方案应用到旋量玻色-爱因斯坦凝聚体中,依旧从处于q=3|c2|的无磁矩态出发,仅仅耗时766ms就制备了具有13.02±0.20dB双模数压缩的三模Dicke态。扣除了已知探测噪声的影响之后,所得到的数压缩更是进一步提高到20.25±1.0dB了,与现今世界上能够实现的最优压缩记录在同一个水平。

图2 实验结果与理论预言的对比。(a)强化学习给出的调控方案(红线)和原有的近绝热方案(黑线)的比较。(b)在两种方案下量子态的演化,线和点分别对应理论模拟和实验测量的结果。实验上制备到的Dicke态的数压缩测量结果(c1)和相干性的测量结果(c2)。

该研究成果以“Faster State Preparation across Quantum Phase Transition Assisted by Reinforcement Learning”为题发表在Physical Review Letters上。物理系2015级博士生郭帅凤(实验)和2017级博士生陈锋(理论)为本文共同第一作者,尤力教授和郑盟锟副教授为通讯作者。该研究工作得到了基金委、科技部、清华大学低维量子物理国家重点实验室、量子信息前沿科学中心、和广东省科技厅的资助。

文章链接:https://journals.aps.org/prl/abstract/10.1103/PhysRevLett.126.060401